标签:ref 包含 str 学习 计算过程 连续 平滑 没有 实践

来源:https://mp.weixin.qq.com/s/k8jj4meb3DKYCGUzaOGDAg

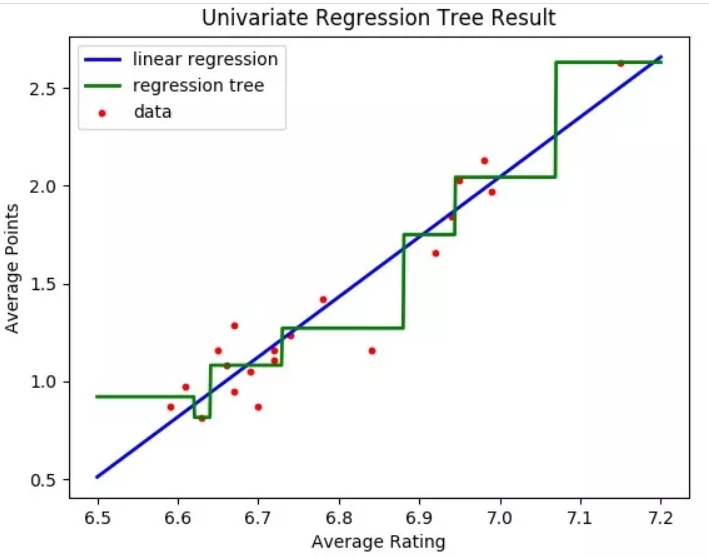

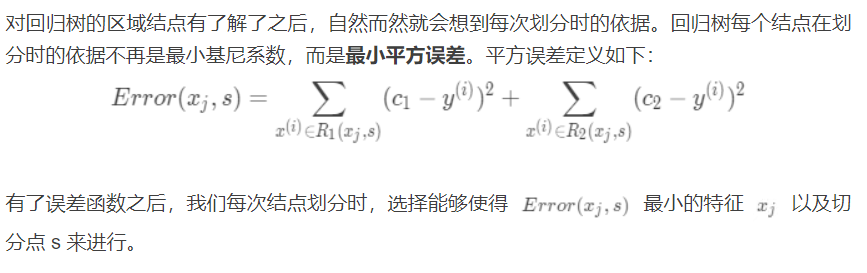

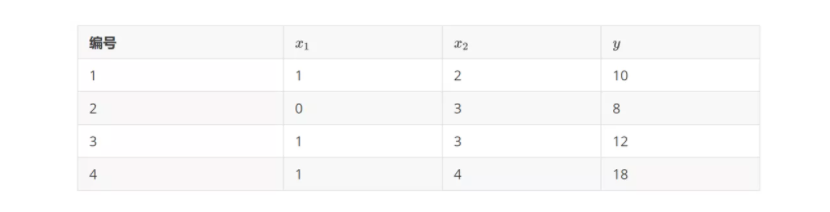

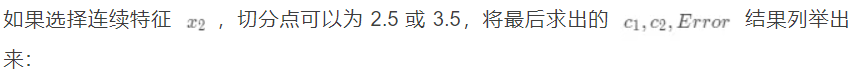

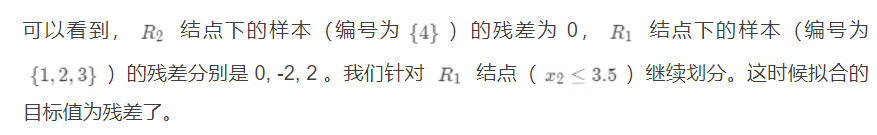

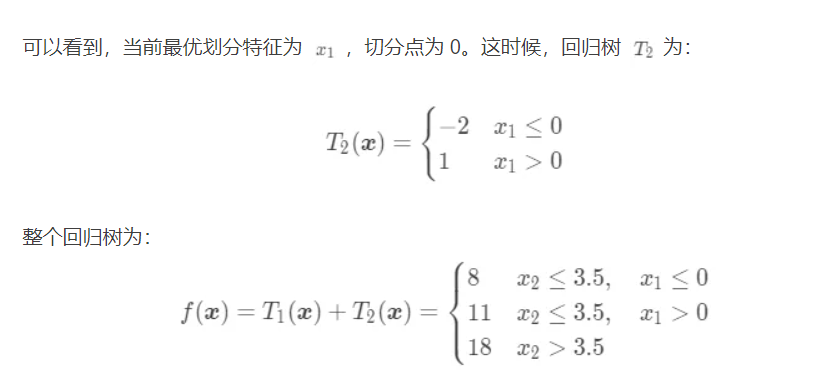

在 决策树进阶 中我们学习到了决策树的剪枝处理,对连续特征以及缺失值的处理。这篇文章来介绍下决策树在解决回归问题中的应用。前面我们知道 CART 能够解决分类问题,实际上它也是可以解决回归问题的。下图是只使用一个特征的情况下 线性回归 与回归决策树的拟合的示意图。

可以看到,相比于 线性回归 对数据的拟合比较平滑,回归决策树的拟合就没有那么平滑了。接下来看下回归决策树的一些理论知识。

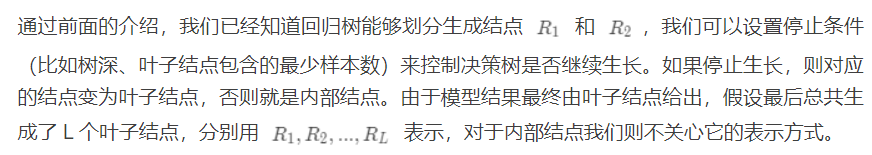

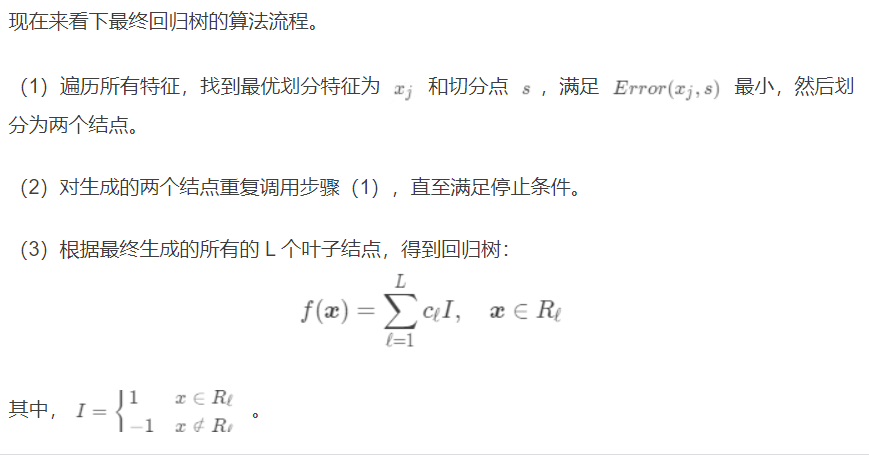

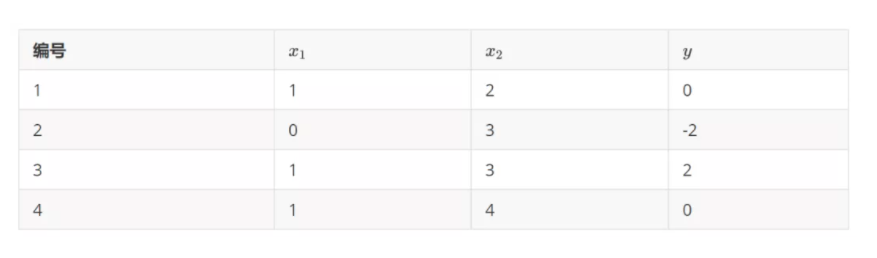

在前面的 决策树基础 学习中,我们已经知道:在使用决策树解决分类问题时,叶子结点的输出是按照多数投票原则决定最终的类别,即该结点下包含样本数最多的类别。在使用决策树进行回归预测时,叶子结点的输出是该结点下所有样本的目标值的均值。

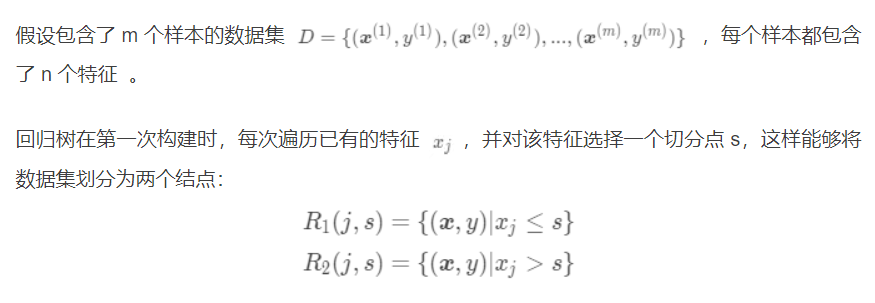

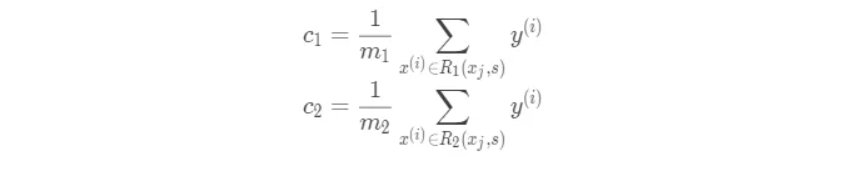

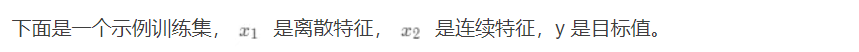

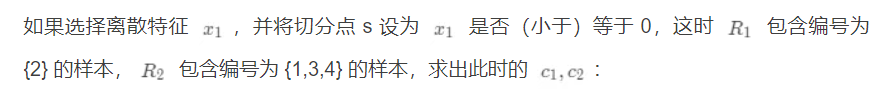

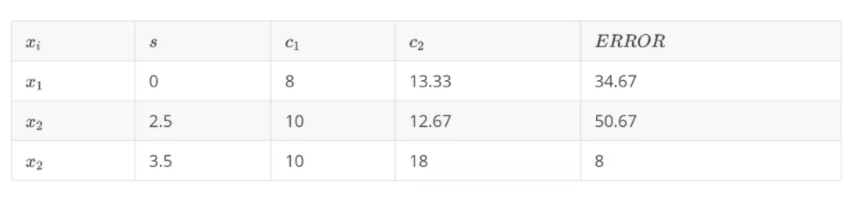

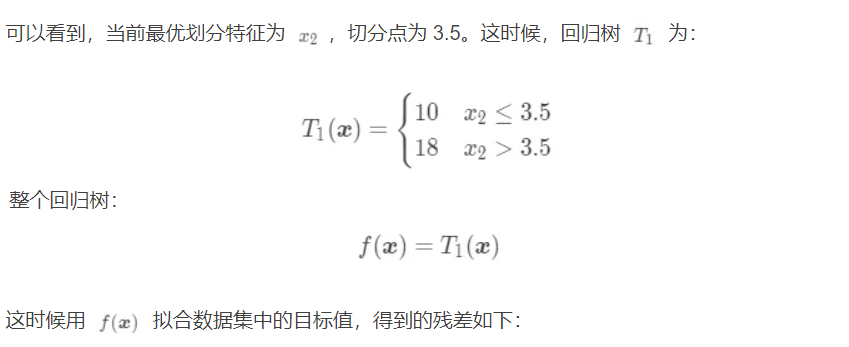

这两个结点对应了特征满足特定条件下的输出值(如果该结点最终是叶子结点,则输出值也就是预测值):

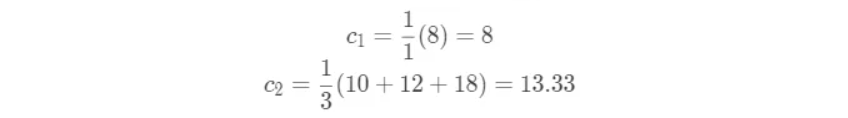

再求出此时的平方误差:

从上面例子中可以看到,决策树从数学上讲就是一个分段函数,它的参数描述的是分段方法。

数据挖掘实践(49):决策树计算过程实例(三)CART回归树及其实战(二)

标签:ref 包含 str 学习 计算过程 连续 平滑 没有 实践

原文地址:https://www.cnblogs.com/qiu-hua/p/14851292.html