标签:des style blog http io ar color os 使用

局部特征(local features),是近来研究的一大热点。大家都了解全局特征(global features),就是方差、颜色直方图等等。如果用户对整个图像的整体感兴趣,而不是前景本身感兴趣的话,全局特征用来描述总是比较合适的。但是无法分辨出前景和背景却是全局特征本身就有的劣势,特别是在我们关注的对象受到遮挡等影响的时候,全局特征很有可能就被破坏掉了。而所谓局部特征,顾名思义就是一些局部才会出现的特征,这个局部,就是指一些能够稳定出现并且具有良好的可区分性的一些点了。这样在物体不完全受到遮挡的情况下,一些局部特征依然稳定存在,以代表这个物体(甚至这幅图像),方便接下来的分析。我们可以看下面这个图,左边一列是完整图像,中间一列是一些角点(就是接下来我们要讲的局部特征),右边一列则是除去角点以外的线段。不知道你会不会也觉得你看中间一列的时候能更敏感地把他们想象成左边一列的原始物品呢?一方面说,如果我们用这些稳定出现的点来代替整幅图像,可以大大降低图像原有携带的大量信息,起到减少计算量的作用。另一方面,当物体受到干扰时,一些冗余的信息(比如颜色变化平缓的部分和直线)即使被遮挡了,我们依然能够从未被遮挡的特征点上还原重要的信息。

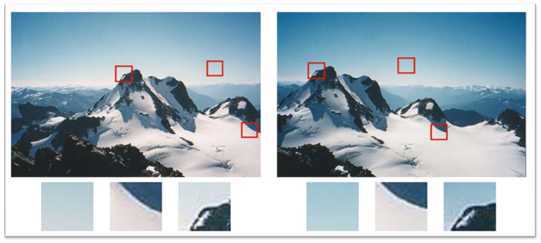

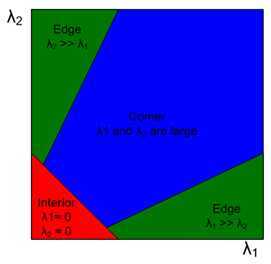

把局部特征说的这么好听,你也许会问怎样的特征能够被当做局部特征点呢?我们不妨来看下面的这幅图:

?

我们选择了3个部分:边缘的点、边缘的线、变化缓慢的天空,当我在左边的图像中选择哪个部分的时候,你最有可能从右边的图像中找到对应的部分来呢?很显然是边缘的点吧。天空,那么多都是一样的;而边缘,一条直线往左看往右看都是差不多的,你让我选哪个点(这也叫做aperture problem);而顶点相比之下更具有唯一性,所以局部特征最初的研究也就是从角点开始的(比如Harris Corner)。

一种定量的检测方法,就是通过SSD去比较两个块区域以定义一个相似度,值越小,两个块越相似:

当然我们应该知道,检测出的块应该和周围有一定的区分性,如何体现这种区分性,不妨做个试验:当前块和它的邻域做匹配,显然自己和自己匹配的时候值最小,而如果周围一定范围的值都特别小,那我们岂不是自己和自己都无法找到匹配,那还拿他当特征干啥?所以如果下式有明显极值,就可以把它当做特征点了。(式中的Δu表示当前块与比较邻域之间的位移)

这个过程就是早期的Harris Corner的核心思想(如果读者想了解Harris Corner的具体细节,请参见该系列的下一篇博客)。

总结一下,好的特征应该具有以下几个特点:

在接下来的几篇文章里,我主要针对局部特征,特别是目前使用的特别火热的SIFT特征和SURF特征进行一些描述和总结。这两个特征都是鲁棒性特别好的局部特征,被广泛应用在模式识别方面。

关于局部特征的更多介绍,请见http://download.csdn.net/download/jiang1st2010/4343689??

在入门篇中偶尔谈到了Harris Corner,在这里我们就重点聊一聊Harris Corner。

?Harris Corner是最典型的角点检测子(Corner Detector)。角点经常被检测在边缘的交界处、被遮挡的边缘、纹理性很强的部分。满足这些条件一般都是稳定的、重复性比较高的点,所以实际上他们是不是角点并不重要(因为我们的目标就是找一些稳定、重复性高的点以作为特征点)。

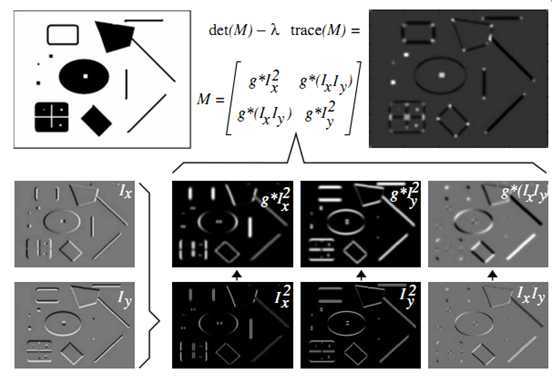

Harris Corner基于二阶矩阵:

????????????????????????????(2.1)

with

???????? (2.2)

(2.3)

这个矩阵描述了局部邻域内梯度的分布情况。矩阵的两个特征值可以用来描述两个主要方向上信号的变化,因此特征值可以用来判决是否为特征点。Harris采用的判别方法是:

(2.4)

显而易见,cornerness的值越大,对应的两个特征值都应该很大,其中λ取0.04,是为了抑制比较明显的直线。最后对整幅图像得到的cornerness做一个非极大抑制,得到最后的特征点。Harris角点具有的优点是平移不变、旋转不变,能克服一定光照变化。可以先从一个例子上观察Harris Corner实现的过程:

现在有几个问题:

首先2.1式矩阵是如何推导出现的;

另外一个问题是为什么2.4式用来决定是否为角点(即为何2.1式的两个特征值可以用来描述两个主要方向上信号的变化强度)。

第一个问题的解答

Harris算子将Moravec算子做了两个推广:

1)用像素的变化梯度代替像素值相减并引入高斯窗函数(举个x方向上变化的例子为证)。

引入高斯窗是为了滤除噪声的干扰。

Gaussian Window

Gaussian Window

Weighted Horizontal Intensity Variation:

Where

X-direction Shift

[-1,0,1]: x方向上的偏导, [-1,0,1]T: y方向上的偏导。

?2)推广出了一个公式这样可以计算任意方向上的像素值变化,而不在是8个固定的方向。

is the convolution operator

(这里的u、v表示x/y方向的位移)

因为的最大值才是这个点需要被考虑的值,因此我们重写以上表达式:

? ? ? ?? (2.5)

Where:

看到M矩阵的形式了么?这就是Harris算子的那个原始矩阵,我想推到这里,你也就应该了解Harris矩阵为什么是这样子的了。?

第二个问题:为什么2.4可以用来描述是否为角点。

那么为什么2.1式的两个特征值能够反映数据在两个方向的变化程度?

注意(2.5)式的目标函数(最大化)。而这个目标函数与PCA的目标函数(通过最大化变化推导PCA的投影方程时)完全一致(如果你记不清这个过程,请你看这里,重点看公式2及之后的文字描述。另外我在这里的留言板中也回答了类似的问题)。特征值是十分重要的概念,不仅在这里以及PCA上,在Laplacian Eigenmaps,LDA上也相应地被使用到。??????

那么又为什么2.4式取值较大时能保证α和β的取值都很大呢?

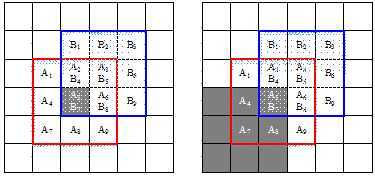

可以参考这样一个图:描述了不同纹理下α和β的取值情况(其中α和β是矩阵M的两个特征值):

这样,当我们把目标函数定义为2.4式的时候,得到的结果就会尽力满足两个特征值都比较大了。当然,除此之外,还有Harmonic mean等方式实现更理想的组合方式达到检测出的两个特征值都尽可能大。

? ? ? ?

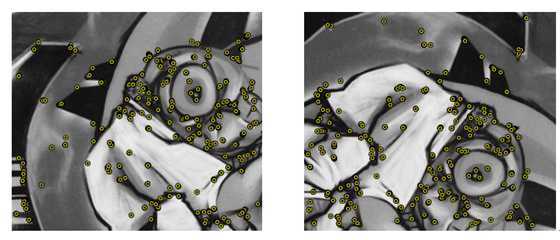

最后附上检测效果图(右图进行了旋转)

两个图可以看出来Harris corner是rotation invariant,但是不是scale invariant。

原文地址:http://blog.csdn.net/jiang1st2010/article/details/7628665

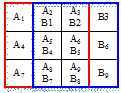

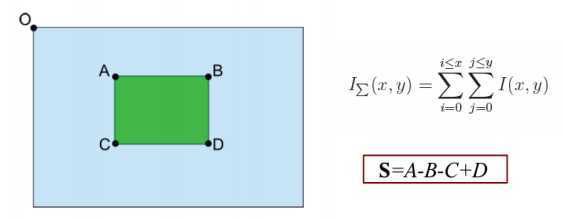

优点:任何一个垂直矩形区域的面积只需要进行3次 +/-法就能计算。一阶的haar小波响应只要5次+/-法就能计算。计算的时间和区域大小无关。

?

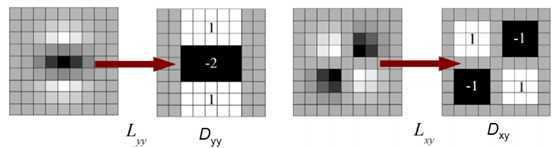

用box filters代替二阶高斯差分模板。

?

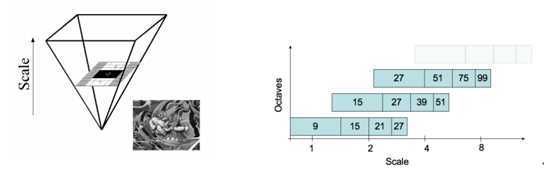

保持图像的大小不变,对box filters进行尺度变换:建立高斯金字塔,金字塔分为多个Octaves,每个Octave分为4个Scale levels。第一级的Octave的模块大小为9、15、21、27(相差6),第二级为15、27、39、51(相差12),第三级为27、51、75、99(相差24)。每一级第一个level的大小为上一级第二个level的大小。继续建立高斯金字塔,直到filter的大小大于原图像的大小为止(问题是大于每一Octave的第一个mask大小还是最后一个mask的大小?)。

? ?

尺度变换的方法,与每个Octave第一个scale level的size(L)/3有关,例如第一个Octave的L为9,L/3=9/3=3,则对于每行/列,连续出现L/3个相同的值,则再插入2个相同的值。若某连续3行同时为1,则再插入两行0。若只连续1行为1,则1*(2/3)=1(四舍五入)。插入的行/列要求左右/上下对称。?

? ? ?

其中w是因为box filters只是高斯二阶差分的近似,为了使行列式的值大致相等,乘以这个权值,取0.9。注意,每Octave提高一级,计算行列式的时候,采样的间隔提高一倍。例如第一个Octave,每个点都计算,到了第二个Octave,隔一个点计算一个……(用增大模板大小,对图像上的点采样计算的方法,等同于实现对图像进行下采样并改变模板尺度的大小。)

对于每一个Octave,对计算出行列式的值设一个阈值,大于该阈值的列为候选兴趣点。对候选极值点进行非极大抑制:对于该level的周围8个点以及上下scale level相应位置的9*2个点,一共26个点进行比较行列式的大小,若该点是周围26个点中行列式最大的,则保留。(每一个Octave的头尾两个scale level是没法计算的。)

为什么可以用Hessian矩阵来判断极小值/极大值,请见最后。?

最后,内插子像素精确定位(具体未看)。?

s = 当前mask大小 * 1.2 / 9

以兴趣点为中心,确定6s为半径的圆。对圆内以s为步长的采样点计算haar小波响应(边长为4s)。

以兴趣点为中心,对小波响应进行高斯加权()。对一个扇形区间(比如π/3)的水平和垂直方向的小波响应分别求和。最长矢量对应的扇形方向就是主方向。(每一个扇形窗可否有重复?)?

附:最近的思考(2011.7.10补充):

我的理解如下:

在x0点上,hessian矩阵是正定的,且各分量的一阶偏导数为0,则x0为极小值点。

在x0点上,hessian矩阵是负定的,且各分量的一阶偏导数为0,则x0为极大值点。

对于某个局部区域,若hessian矩阵是半正定的,则这个区域是凸的(反之依然成立);若负定,则这个区域是凹的(反之依然成立)。而对于正定和负定来说,Hessian矩阵的行列式总是大于等于0的。反过来就是说:某个点若是极大值/极小值,hessian矩阵的行列式必然要大于等于0,而大于等于0如果是满足的,这个点不一定是极大值/极小值(还要判断一阶导数)。所以后面还要进行极大值抑制。

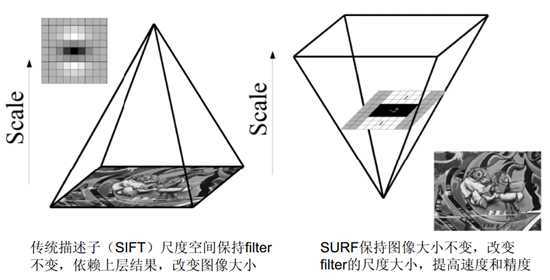

与SURF相关的局部特征是SIFT,已经有很多专家对它讨论过了,这里我也不再多谈,如果大家对它感兴趣的话,请看这里,而接下来的这篇博客则对SIFT和SURF做了比较

原文地址:http://blog.csdn.net/jiang1st2010/article/details/6564835

SIFT/SURF为了实现不同图像中相同场景的匹配,主要包括三个步骤:

从博客上看到一片文章,http://blog.csdn.net/cy513/archive/2009/08/05/4414352.aspx,这一段的大部分内容源于这篇文章,推荐大家去看看。

如果两幅图像中的物体一般只是旋转和缩放的关系,加上图像的亮度及对比度的不同,要在这些条件下要实现物体之间的匹配,SIFT算法的先驱及其发明者想到只要找到多于三对物体间的匹配点就可以通过射影几何的理论建立它们的一一对应。

如何找到这样的匹配点呢?SIFT/SURF作者的想法是首先找到图像中的一些"稳定点",这些点是一些特殊的点,不会因为视角的改变、光照的变化、噪音的干扰而消失,比如角点、边缘点、暗区域的亮点以及亮区域的暗点。这样如果两幅图像中有相同的景物,那么这些稳定点就会在两幅图像的相同景物上同时出现,这样就能实现匹配。因此,SIFT/SURF算法的基础是稳定点。

SIFT/SURF提取的稳定点,首先都要求是局部极值。但是,当两个物体的大小比例不一样时,大图像的局部极值点在小图像的对应位置上有可能不是极值点。于是SIFT/SURF都采用图像金字塔的方法,每一个截面与原图像相似,这样两个金字塔中就有可能包含大小最近似的两个截面了。

这样找到的特征点会比较多,经过一些处理后滤掉一些相对不稳定的点。

接下来如何去匹配相同物体上对应的点呢?SIFT/SURF的作者都想到以特征点为中心,在周围邻域内统计特征,将特征附加到稳定点上,生成特征描述子。在遇到旋转的情况下,作者们都决定找出一个主方向,然后以这个方向为参考坐标进行后面的特征统计,就解决了旋转的问题。

为什么是DOG的金字塔?因为它接近LOG,而LOG的极值点提供了最稳定的特征,而且DOG方便计算(只要做减法。)

为什么LOG的极值点提供的特征最稳定,有参考文献,未看。

(7.12补充:)直观理解:特征明显的点经过不同尺度的高斯滤波器进行滤波后,差别较大,所以用到的是DOG。

但是直观上怎么理解?如果相邻Octave的sigma不是两倍关系还好理解:如果两幅图像只是缩放的关系,那么假设第一个Octave找到了小一倍图像的极值点,那么大一倍图像的极值点会在下一个Octave找到相似的。但是现在,如果把大一倍图像进行一次下采样(这样和小的图像就完全一样了),进行Gauss滤波时,两个图像滤波系数(sigma)是不一样的,不就找不到一样的极值点了么?不理解。

SIFT先利用非极大抑制,再用到Hessian矩阵进行滤除。SURF先用Hessian矩阵,再进行非极大抑制。SURF的顺序可以加快筛选速度么?(Hessian矩阵滤除的点更多?)

至于SURF先用Hessian矩阵,再进行非极大抑制的原因,是不管先极大值抑制还是判断Hessian矩阵的行列式,金字塔上的点的行列式都是要计算出来的。先判断是否大于0只要进行1次判断,而判断是否是极大值点或者极小值点要与周围26个点比较,只比较1次肯定快。

而在SIFT中,构建的高斯金字塔只有一座(不想SURF是有3座),要进行非极大抑制可以直接用金字塔的结果进行比较。而如果计算Hessian矩阵的行列式,还要再计算Dxx、Dxy、Dyy。因此先进行非极大抑制。这两个步骤的先后与SIFT/SURF的实际计算情况有关的,都是当前算法下的最佳顺序,而不是说哪种先计算一定更好。

这与人的视觉神经相关。采用梯度作为描述子的原因是,人的视觉皮层上的神经元对特定方向和空间频率的梯度相应很敏感,经过SIFT作者的一些实验验证,用梯度的方法进行匹配效果很好。

我在一份博客上找到这样一句话:(http://apps.hi.baidu.com/share/detail/32318290,大家可以看看这篇文章。)

从直观的人类视觉印象来看,人类视觉对物体的描述也是局部化的,基于局部不变特征的图像识别方法十分接近于人类视觉机理,通过局部化的特征组合,形成对目标物体的整体印象,这就为局部不变特征提取方法提供了生物学上的解释,因此局部不变特征也得到了广泛应用。

?还有:

图像中的每个局部区域的重要性和影响范围并非同等重要,即特征不是同等显著的,其主要理论来源是Marr的计算机视觉理论和Treisman的特征整合理论,一般也称为"原子论"。该理论认为视觉的过程开始于对物体的特征性质和简单组成部分的分析,是从局部性质到大范围性质。

SIFT/SURF都是对特征点的局部区域的描述,这些特征点应该是影响重要的点,对这些点的分析更加重要。所以在局部不变特征的提取和描述时也遵循与人眼视觉注意选择原理相类似的机制,所以SIFT/SURF用于匹配有效果。?

从博客上看到一个总结,我修改了一些内容。大家可以参看以下链接:

http://blog.csdn.net/ijuliet/archive/2009/10/07/4640624.aspx

?? | SIFT | SURF |

尺度空间 | DOG与不同尺度的图片卷积 | 不同尺度的box filters与原图片卷积 |

特征点检测 | 先进行非极大抑制,再去除低对比度的点。再通过Hessian矩阵去除边缘的点 | 先利用Hessian矩阵确定候选点,然后进行非极大抑制 |

方向 | 在正方形区域内统计梯度的幅值的直方图,找max对应的方向。可以有多个方向。 | 在圆形区域内,计算各个扇形范围内x、y方向的haar小波响应,找模最大的扇形方向 |

特征描述子 | 16*16的采样点划分为4*4的区域,计算每个区域的采样点的梯度方向和幅值,统计成8bin直方图,一共4*4*8=128维 (2013.5.9 note: 不一定要是16?× 16,区域也可以不用是 4?× 4) | 20*20s的区域划分为4*4的子区域,每个子区域找5*5个采样点,计算采样点的haar小波响应,记录∑dx,∑dy,∑|dx|,∑|dy|,一共4*4*4=64维 |

SURF金字塔仅仅是用来做特征点的检测。在计算描述子的时候,haar小波响应是计算在原图像(利用积分图)。而SIFT是计算在高斯金字塔上(注意不是高斯差分金字塔。)

论文:A comparison of SIFT, PCA-SIFT and SURF?对三种方法给出了性能上的比较,源图片来源于Graffiti dataset,对原图像进行尺度、旋转、模糊、亮度变化、仿射变换等变化后,再与原图像进行匹配,统计匹配的效果。效果以可重复出现性为评价指标。

比较的结果如下:

method | Time | Scale | Rotation | Blur | Illumination | Affine |

Sift | common | best | best | common | common | good |

Pca-sift | good | good | good | best | good | best |

Surf | best | common | common | good | best | good |

? ?

? ?

? ?

? ?

由此可见,SIFT在尺度和旋转变换的情况下效果最好,SURF在亮度变化下匹配效果最好,在模糊方面优于SIFT,而尺度和旋转的变化不及SIFT,旋转不变上比SIFT差很多。速度上看,SURF是SIFT速度的3倍。

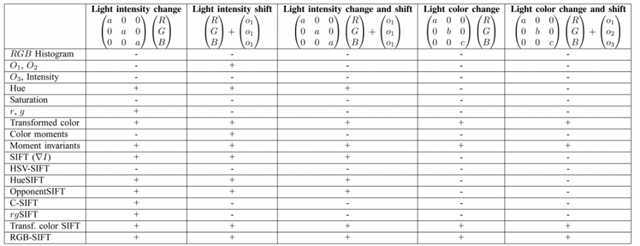

前面两讲中主要是针对SIFT和SURF做了一些介绍。他们的检测子比较稳定,描述子比较鲁棒,好像非常棒的样子。但是有一点非常遗憾,就是他们在对图像进行处理的过程中,都把图像转化为灰度图像进行处理,这样就丢失了颜色信息。而颜色,本身提供了很大的信息量,丢失了特别可惜。很多人可能就会想,如何在描述子中加入颜色信息。在这一讲中,我们就重点介绍一下改进的SIFT/SURF的Color Descriptor。

这里的Descriptor,其实我们可以把它当做大家传统上理解的特征。而特征,应该具有两个比较重要的特点。第一就是它应该是最有区分度、最有代表性的,应该尽可能减少冗余的信息。如果对于大多数物体来说,这个变量的值非常相近,没有什么区分性,自然不适合做特征。而另一个方面,它应该尽可能的稳定和鲁棒。对于同样的物体来说,当它因为噪声的变化或者图像的旋转、尺度变换等影响时,这个变量的值应该是尽可能不变的(invariant)。?我们要评价一个描述子是否鲁棒,重点就看图像被加入噪声后,形成的描述子是否依然稳定(也就是特征的各维是否不发生变化)。这里所谓的噪声,无外乎以下几种:

这里几乎把所有可能发生的线性变化都列出来了。可以考虑到,现有的灰度的SIFT/SURF特征对于(1)-(3)的变化具有不变性。

这主要得益于:

这样的话,我们需要考虑的就是如何解决(4)-(5)的颜色上的变化了。在此之前,我们先看看目前不用在SIFT/SURF上有哪些颜色特征,然后考虑把这些颜色特征放到描述子中。

最常见的颜色直方图,你懂的,但是不具有任何不变性,想到这里以后还是换个特征用吧。

O1和O2表征了颜色信息,对light intensity shift是不变的,不过O3这个直接与灰度相关的变量就不是了。

这个大家也熟悉,它对灰度的尺度变化和增量变化具有不变性。所以说HSV颜色空间对于RGB颜色空间,在这一点上有着优势。

相当于对rgb分量做了一个归一化,归一化之后r/g分量就可以描述图像的颜色信息。其中b分量是多余的,因为r+g+b=1。Rg直方图对light intensity change是不变的,对于存在阴影的场景中可以尝试用。

考虑到rgb直方图对于灰度和颜色的线性变化不具有任何不变性,但是如果我们考虑对RGB三个通道分别做归一化,归一化的方法如:

这样,通过减去均值可以抵消各通道的value shift,通过除以方差可以抵消各通道的value scale change。(均值和方差以待统计的块为单位进行计算。)这样归一化之后的直方图对于light color change and shift是具有不变性的。

?列举了颜色直方图的几种统计方法之后,我们可以把他们用在SIFT/SURF描述子之中。因为传统的SIFT/SURF描述子是对单通道进行统计的,当使用上述特征进行统计时,就是对多个通道分别计算描述子,最后形成一个多维的特征作为颜色描述子。

重点想提一下的就是:

C-SIFT:利用Opponent information中的 O1/O3和O2/O3作为颜色特征,这么做的目的是为了消除O1和O2中的灰度信息,但是,这样做却不能对intensity shift有不变性。

Transformed color SIFT:这个特征将不仅对灰度的change和shift具有不变性,同时还对各颜色的shift和change都具有不变性;

RGB-SIFT:很有意思的就是由于Transformed color SIFT对各通道的线性变化都具有不变性,而Transformed就是RGB特征经过线性变换而来,因此RGB-SIFT和Transformed color SIFT具有同样的不变性(效果是一样的)。

最后,对上面介绍的所有特征的不变性做一个总结,见下表,其中"+"表示对这一变化具有不变性,"-"则表示不具有这种不变性。

原文地址:http://blog.csdn.net/jiang1st2010/article/details/7647766

找到了一篇比较好的关于几种重要局部特征的综述,原文地址:http://www.sigvc.org/bbs/thread-165-1-1.html?。如果有谁找到更加丰富的,涉及到HOG、LBP等特征一起加以比较的文章,请告诉我,一起分享。

局部图像特征描述是计算机视觉的一个基本研究问题,在寻找图像中的对应点以及物体特征描述中有着重要的作用。它是许多方法的基础,因此也是目前视觉研究中的一个热点,每年在视觉领域的顶级会议ICCV/CVPR/ECCV上都有高质量的特征描述论文发表。同时它也有着广泛的应用,举例来说,在利用多幅二维图像进行三维重建、恢复场景三维结构的应用中,其基本出发点是要有一个可靠的图像对应点集合,而自动地建立图像之间点与点之间的可靠对应关系通常都依赖于一个优秀的局部图像特征描述子。又比如,在物体识别中,目前非常流行以及切实可行的方法之一是基于局部特征的,由于特征的局部性,使得物体识别可以处理遮挡、复杂背景等比较复杂的情况。

局部图像特征描述的核心问题是不变性(鲁棒性)和可区分性。由于使用局部图像特征描述子的时候,通常是为了鲁棒地处理各种图像变换的情况。因此,在构建/设计特征描述子的时候,不变性问题就是首先需要考虑的问题。在宽基线匹配中,需要考虑特征描述子对于视角变化的不变性、对尺度变化的不变性、对旋转变化的不变性等;在形状识别和物体检索中,需要考虑特征描述子对形状的不变性。

然而,特征描述子的可区分性的强弱往往和其不变性是矛盾的,也就是说,一个具有众多不变性的特征描述子,它区分局部图像内容的能力就稍弱;而如果一个非常容易区分不同局部图像内容的特征描述子,它的鲁棒性往往比较低。举个例子,假定我们需要对一个点周围固定大小的局部图像内容进行描述。如果我们直接将图像内容展开成一个列向量对其进行描述,那么只要局部图像内容发生了一点变化,就会使得它的特征描述子发生较大的变化,因此这样的特征描述方式很容易区分不同的局部图像内容,但是对于相同的局部图像内容发生旋转变化等情况,它同样会产生很大的差异,即不变性弱。

而另一方面,如果我们通过统计局部图像灰度直方图来进行特征描述,这种描述方式具有较强的不变性,对于局部图像内容发生旋转变化等情况比较鲁棒,但是区分能力较弱,例如无法区分两个灰度直方图相同但内容不同的局部图像块。

综上所述,一个优秀的特征描述子不仅应该具有很强不变性,还应该具有很强的可区分性。

在诸多的局部图像特征描述子中,SIFT(Scale Invariant Feature Transform)是其中应用最广的,它在1999年D. Lowe首次提出,至2004年得到完善。SIFT的提出也是局部图像特征描述子研究领域一项里程碑式的工作。由于SIFT对尺度、旋转以及一定视角和光照变化等图像变化都具有不变性,并且SIFT具有很强的可区分性,自它提出以来,很快在物体识别、宽基线图像匹配、三维重建、图像检索中得到了应用,局部图像特征描述子在计算机视觉领域内也得到了更加广泛的关注,涌现了一大批各具特色的局部图像特征描述子。

SURF(Speeded Up Robust Features)是对SIFT的改进版本,它利用Haar小波来近似SIFT方法中的梯度操作,同时利用积分图技术进行快速计算,SURF的速度是SIFT的3-7倍,大部分情况下它和SIFT的性能相当,因此它在很多应用中得到了应用,尤其是对运行时间要求高的场合。

DAISY是面向稠密特征提取的可快速计算的局部图像特征描述子,它本质思想和SIFT是一样的:分块统计梯度方向直方图,不同的是,DAISY在分块策略上进行了改进,利用高斯卷积来进行梯度方向直方图的分块汇聚,这样利用高斯卷积的可快速计算性就可以快速稠密地进行特征描述子的提取。比较巧合的是,DAISY这种特征汇聚策略被一些研究者(Matthen Brown,Gang Hua,Simon Winder)通过机器学习的方法证明相对于其他几种特征汇聚策略(卡迪尔坐标下分块、极坐标下分块)是最优的。

ASIFT(Affine SIFT)通过模拟所有成像视角下得到的图像进行特征匹配,可以很好地处理视角变化的情况,尤其是大视角变化下的图像匹配。

MROGH(Multi-support Region Order-based Gradient Histogram)则是特征汇聚策略上寻求创新,之前的局部图像特征描述子,其特征汇聚策略都是基于邻域内点的几何位置的,而MROGH基于点的灰度序进行特征汇聚。

BRIEF(Binary Robust Independent Element Feature)利用局部图像邻域内随机点对的灰度大小关系来建立局部图像特征描述子,得到的二值特征描述子不仅匹配速度快,而且存储要求内存低,因此手机应用中具有很好的应用前景。其实,利用邻域内点对的灰度大小关系进行特征描述这一思想在SMD(ECCV‘08)中就已经有了。

除了BRIEF,近两年还提出了许多二值特征描述子,例如ORB、BRISK、FREAK。上述这些特征描述子都是基于手动设计得到的,也有一些研究试图利用机器学习的方法,通过数据驱动得到想要的特征描述子。这类特征描述子包括PCA-SIFT,Linear Discriminative Embedding,LDA-Hash等。当然,除了提到到的这些特征描述子之外,还有许多其他的特征描述子,在这就不再一一叙述了。

国际上研究局部图像特征描述子比较著名的学者有:英国Surrey大学的Mikolajzyk,他在INRIA做博后的时候,在宽基线应用背景下,对SIFT、Shape Context、PCA-SIFT、不变矩等多种局部图像描述子的性能进行了评测,相关论文发表在2005年PAMI上,他提出来的评测方法至今仍是局部图像描述子研究领域中广泛采用的性能评测方法。

INRIA的C. Schmid,她九十年代就开始研究局部图像描述方法了,是这个领域内的元老之一,不过这几年她的团队正在将重心转向大规模图像检索和行为识别等应用中。

比利时Leuven大学的Tinne Tuytelaars,她是著名的SURF描述子的提出者,SURF相关的论文于2011年获得CVIU引用最多论文奖,她写了三篇局部图像特征描述相关的综述文章,分别是"Local Invariant Feature Detectors: A Survey","Local Image Features"和"Wide baseline matching"。

英国Oxford大学的Andrea Vedaldi,他是Vlfeat的发起者和主要作者。Vlfeat是一个开源程序,其中包括了SIFT、MSER,被许多研究者广泛采用。Vlfeat目前正在逐渐实现其他常用的特征描述子。

瑞士EPFL的Vincent Lepetit和Pascal Fua,他们的团队主要致力于发展快速、高效的局部图像特征描述子,用于模板匹配、三维重建、虚拟现实等应用。他们的工作包括用于稠密立体匹配的DAISY特征描述子,基于Random Trees的模板匹配方法,基于Random Ferns的模板匹配方法。此外,LDA-Hash、BRIEF、D-BRIEF(ECCV 2012)也是他们的杰作。

中国科学院自动化研究所的吴福朝研究员,他在这方面也做了比较深入的研究,并提出了许多不错的局部图像特征提取和描述方法。这些名字都是我们在读论文的时候会经常看到的。

最近几年局部图像特征描述子的发展趋势是:快速、低存储。这两个趋势使得局部图像特征描述子可以在快速实时、大规模应用中发挥作用,而且有利于将许多应用做到手机上去进行开发,实实在在的将计算机视觉技术应用于我们周围的世界中。为了满足快速和低存储这两个需求,二值特征描述子得到了研究者的广泛关注,这两年CVPR和ICCV中关于局部图像特征描述子的文章,大部分都是这类的。相信它们在未来几年还会继续受到关注,期待出现一些深入大众生活中的成功应用。

原文地址:http://blog.csdn.net/jiang1st2010/article/details/8909709

标签:des style blog http io ar color os 使用

原文地址:http://www.cnblogs.com/CVFans/p/4107405.html