标签:

本系列内容大部分来自Standford公开课machine learning中Andrew老师的讲解,附加自己的一些理解,编程实现和学习笔记。

第一章 Logistic regression

1.逻辑回归

逻辑回归是一种监督学习的分类算法,相比较之前的线性回归算法,差别在于它是一个分类算法,这也意味着y不再是一个连续的值,而是{0,1}的离散值(两类问题的情况下)。

当然这依然是一个判别学习算法,所谓判别学习算法,就是我们直接去预测后验 ,或者说直接预测判别函数的算法。当然相对应的生成学习算法,之后应该会写一篇博客来解释两者之间的联系与区别,优点与缺点。

回到正题,在之前linear regression的概率解释中,我们假设了误差是独立同分布(IID)的高斯分布;

而在Logistic regression中我们需要假设的是事件符合伯努利分布

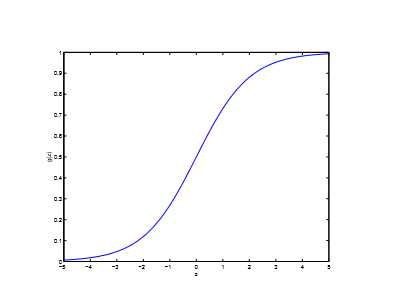

其中,这个函数被称为logistic function或者sigmoid function,这也是一个最为常用的激活函数,它的图像:

很显然g(z)的值域在0~1,且z趋向于正无穷是g(z)=1,z趋向于负无穷是g(z)=0;

(这个性质在这里我就不推导了)

我们假设m个样本独立同分布(IID),那么似然函数为:

接下来的问题就相当熟悉了,我们可以使用梯度下降,最大似然函数。

我们不妨对于单个参数先进行推导:

由(1)得

最后我们发现我们得到的迭代公式与之前的线性回归得到的迭代公式一模一样

当然这肯定不可能是巧合,它存在着一定的更深层的原因,这也会在之后的广义线性模型中来解释。

逻辑回归 logistic regression(1)逻辑回归的求解和概率解释

标签:

原文地址:http://www.cnblogs.com/samsons/p/4419190.html