http://blog.csdn.net/pipisorry/article/details/45651315

cosin余弦相似度

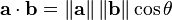

两个向量间的余弦值可以很容易地通过使用欧几里得点积和量级公式推导:

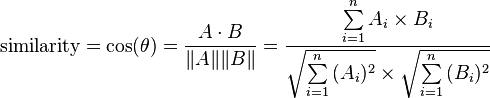

鉴于两个向量的属性, A 和B的余弦相似性θ用一个点积形式来表示其大小,如下所示:

产生的相似性范围从-1到1:-1意味着两个向量指向的方向正好截然相反,1表示它们的指向是完全相同的,0通常表示它们之间是独立的,而在这之间的值则表示中度的相似性或相异性。 对于文本匹配,属性向量A 和B 通常是文档中的词频向量。余弦相似性,可以被看作是一个规范比较文件长度的方法。 在信息检索的情况下,由于一个词的频率(TF-IDF权)不能为负数,所以这两个文档的余弦相似性范围从0到1。并且,两个词的频率向量之间的角度不能大于90°。

[余弦相似性]

kl散度/相对熵

相对熵(relative entropy)又称为KL散度(Kullback–Leibler divergence,简称KLD),信息散度(information divergence),信息增益(information gain)。

KL散度是两个概率分布P和Q差别的非对称性的度量。 KL散度是用来 度量使用基于Q的编码来编码来自P的样本平均所需的额外的位元数。 典型情况下,P表示数据的真实分布,Q表示数据的理论分布,模型分布,或P的近似分布。

定义

对于离散随机变量,其概率分布P 和Q的KL散度可按下式定义为

即按概率P求得的P和Q的对数差的平均值。KL散度仅当概率P和Q各自总和均为1,且对于任何i皆满足 及

及 时,才有定义。式中出现

时,才有定义。式中出现 的情况,其值按0处理。

的情况,其值按0处理。

特性

相对熵的值为非负数:

由吉布斯不等式(en:Gibbs‘ inequality)可知,当且仅当P = Q时DKL(P||Q)为零。

尽管从直觉上KL散度是个度量或距离函数, 但是它实际上并不是一个真正的度量或距离。因为KL散度不具有对称性:从分布P到Q的距离(或度量)通常并不等于从Q到P的距离(或度量)。

ref:如何计算两个文档的相似度

原文地址:http://blog.csdn.net/pipisorry/article/details/45651315