标签:

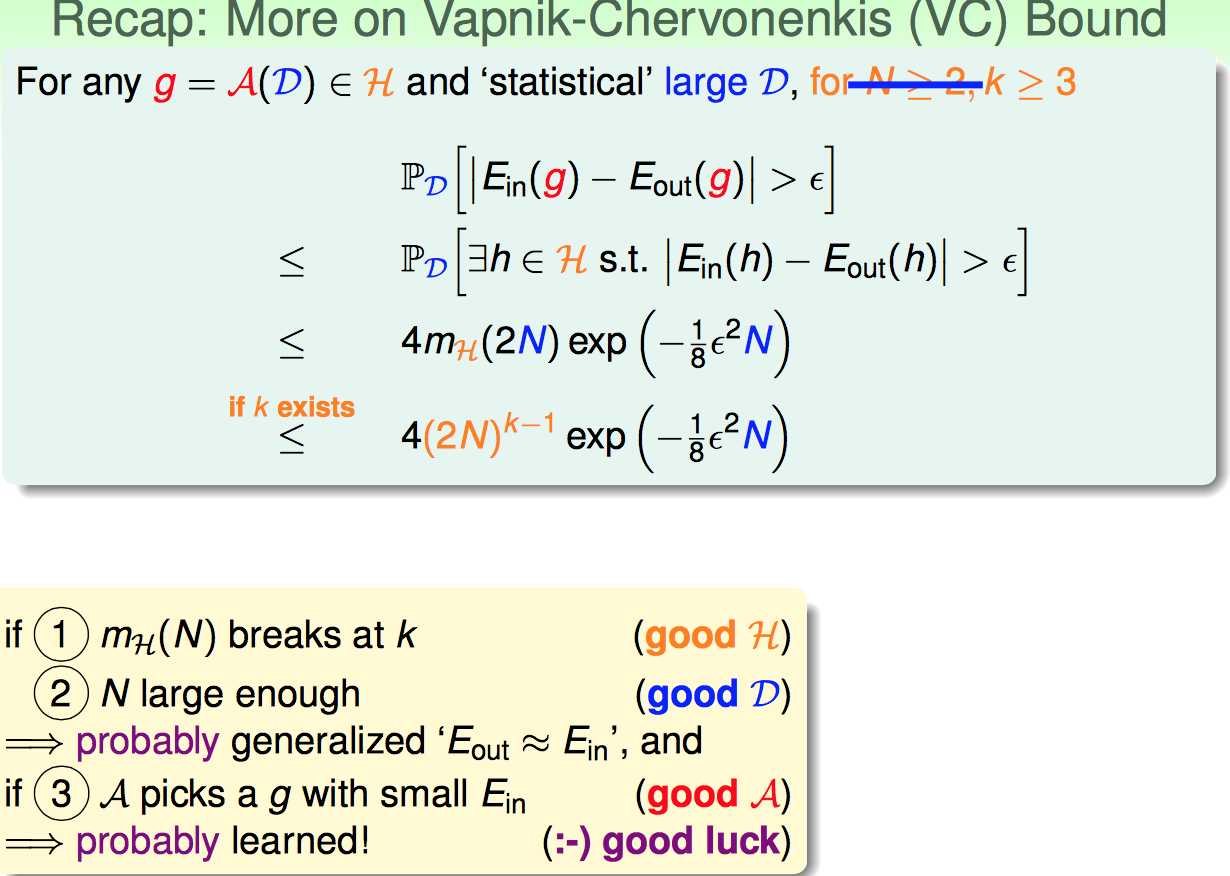

首先回顾上节课末尾引出来的VC Bound概念,对于机器学习来说,VC dimension理论到底有啥用。

三点:

1. 如果有Break Point证明是一个好的假设集合

2. 如果N足够大,那么Ein跟Eout的表现会比较接近

3. 如果算法A选的g足够好(Ein很小),则可能从数据中学到了东西

==================================================

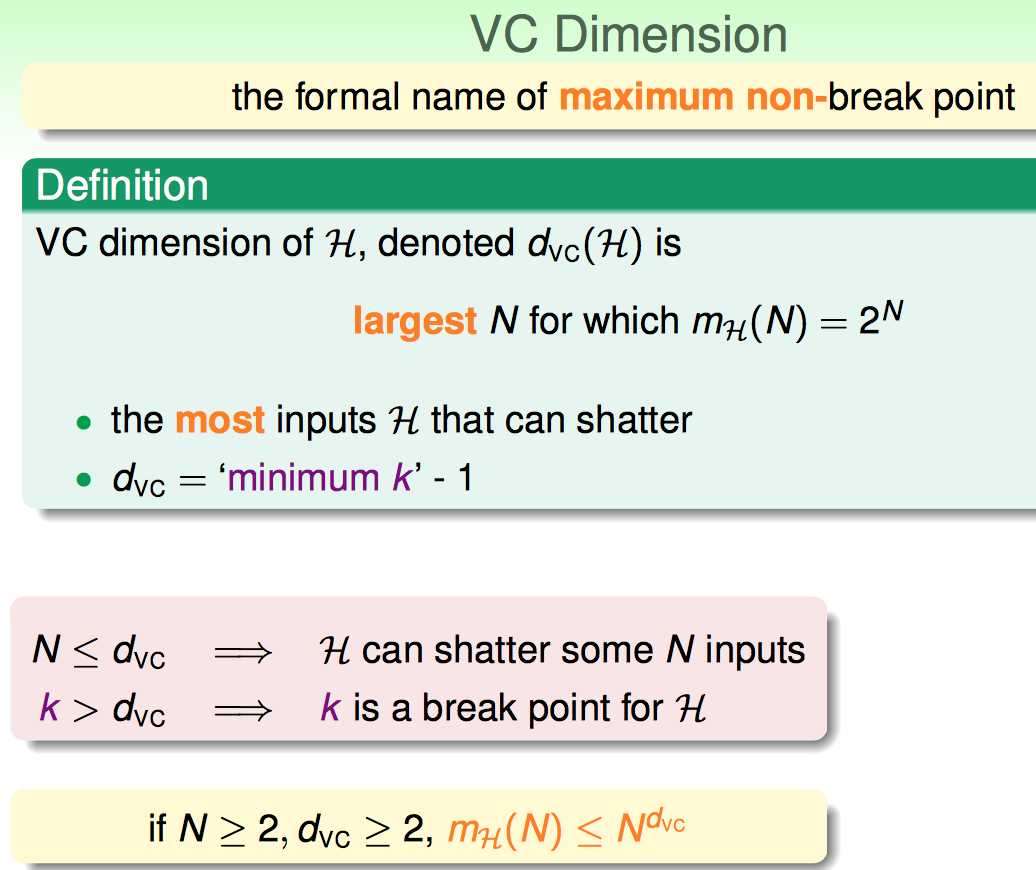

现在正式引出VC Dimension的概念:啥叫VC Dimension:

VC Dimension是针对某个假设集合的一个性质。简言之,就是Break Point - 1的那个值的正式说法。如果没有Break Point,则VC Dimension是无限。

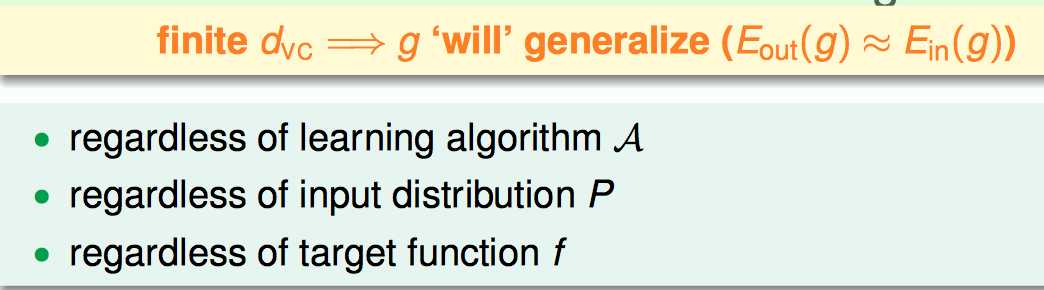

因此,VC Dimension有限被认为是好的。

为啥是好的呢?回顾之前几节的内容,有如下的结论证明VC Dimension有限是好的(样本充足情况下,可以保证Eout跟Ein接近)

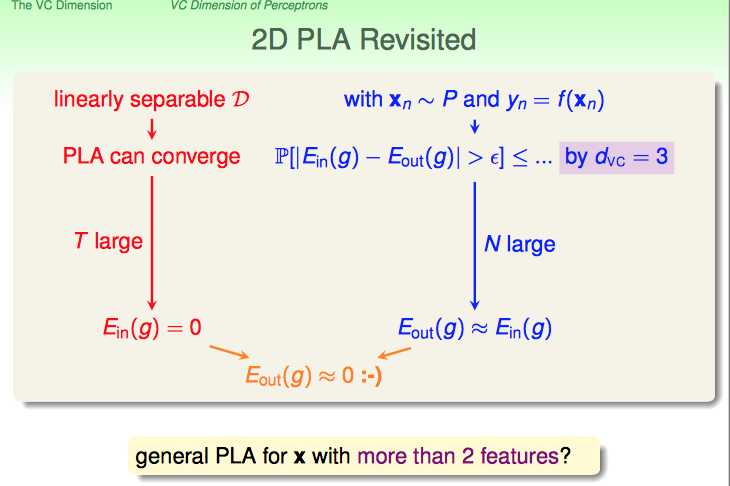

马上举一个例子,证明VC Dimension的用处:

对于2D PLA来说:

1. 如果是linear separable D , 则迭代次数足够,一定可以得到Ein(out)是0 (从训练集学到了东西)

2. 二维平面上 binary classification的VC Dimension是3,因此N足够大时候,Ein与Eout很接近(训练集的学习效果可以迁移到测试集)

端午放假出去散心。。。回来接着写。。。。

=======================================================================

标签:

原文地址:http://www.cnblogs.com/xbf9xbf/p/4589696.html