标签:

贝叶斯分类器的分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。目前研究较多的贝叶斯分类器主要有四种,分别是:Naive Bayes、TAN、BAN 和 GBN。贝叶斯网络是一个带有概率注释的有向无环图,图中的每一个结点均表示一个随机变量,图中两结点间若存在着一条弧,则表示这两结点相对应的随机变量是概率相依的,反之则说明这两个随机变量是条件独立的。网络中任意一个结点 X 均有一个相应的条件概率表(Conditional Probability Table,CPT),用以表示结点 X 在其父结点取各可能值时的条件概率。若结点 X 无父结点,则 X 的 CPT 为其先验概率分布。贝叶斯网络的结构及各结点的 CPT 定义了网络中各变量的概率分布。贝叶斯分类器是用于分类的贝叶斯网络。该网络中应包含类结点 C,其中 C 的取值来自于类集合( c1 , c2 , ... , cm),还包含一组结点 X = ( X1 , X2 , ... , Xn),表示用于分类的特征。

对于贝叶斯网络分类器,若某一待分类的样本 D,其分类特征值为 x = ( x1 , x2 , ... , x n) ,则样本 D 属于类别 ci 的概率 P( C = ci | X1 = x1 , X2 = x 2 , ... , Xn = x n) , ( i = 1 ,2 , ... , m) 应满足下式:

P( C = ci | X = x) = Max{ P( C = c1 | X = x) , P( C = c2 | X = x ) , ... , P( C = cm | X = x ) }

而由贝叶斯公式:

P( C = ci | X = x) = P( X = x | C = ci) * P( C = ci) / P( X = x)

其中, P( C = ci) 可由领域专家的经验得到,而 P( X = x | C = ci) 和 P( X = x) 的计算则较困难。应用贝叶斯网络分类器进行分类主要分成两阶段。第一阶段是贝叶斯网络分类器的学习,即从样本数据中构造分类器,包括结构学习和 CPT 学习;第二阶段是贝叶斯网络分类器的推理,即计算类结点的条件概率,对分类数据进行分类。这两个阶段的时间复杂性均取决于特征值间的依赖程度,甚至可以是 NP 完全问题,因而在实际应用中,往往需要对贝叶斯网络分类器进行简化。根据对特征值间不同关联程度的假设,可以得出各种贝叶斯分类器,Naive Bayes、TAN、BAN、GBN 就是其中较典型、研究较深入的贝叶斯分类器。

分类是将一个未知样本分到几个预先已知类的过程。数据分类问题的解决是一个两步过程:第一步,建立一个模型,描述预先的数据集或概念集。通过分析由属性描述的样本(或实例,对象等)来构造模型。假定每一个样本都有一个预先定义的类,由一个被称为类标签的属性确定。为建立模型而被分析的数据元组形成训练数据集,该步也称作有指导的学习。在众多的分类模型中,应用最为广泛的两种分类模型是决策树模型(Decision Tree Model)和朴素贝叶斯模型(Naive Bayesian Model,NBC)。决策树模型通过构造树来解决分类问题。首先利用训练数据集来构造一棵决策树,一旦树建立起来,它就可为未知样本产生一个分类。在分类问题中使用决策树模型有很多的优点,决策树便于使用,而且高效;根据决策树可以很容易地构造出规则,而规则通常易于解释和理解;决策树可很好地扩展到大型数据库中,同时它的大小独立于数据库的大小;决策树模型的另外一大优点就是可以对有许多属性的数据集构造决策树。决策树模型也有一些缺点,比如处理缺失数据时的困难,过度拟合问题的出现,以及忽略数据集中属性之间的相关性等。和决策树模型相比,朴素贝叶斯模型发源于古典数学理论,有着坚实的数学基础,以及稳定的分类效率。同时,NBC 模型所需估计的参数很少,对缺失数据不太敏感,算法也比较简单。理论上, NBC 模型与其他分类方法相比具有最小的误差率。但是实际上并非总是如此,这是因为 NBC 模型假设属性之间相互独立,这个假设在实际应用中往往是不成立的,这给NBC 模型的正确分类带来了一定影响。在属性个数比较多或者属性之间相关性较大时,NBC模型的分类效率比不上决策树模型。而在属性相关性较小时,NBC 模型的性能最为良好。假设数据集合为D,H为假设空间(类别空间),h为其中一假设,hMAP为假设空间上的最大后验概率。

![]()

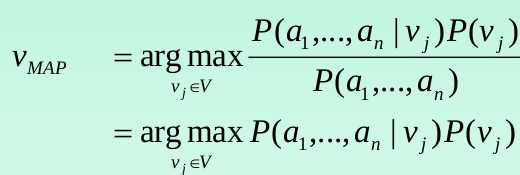

上面的hMAP为推导的基础,那么贝叶斯问题的推导大致要经过以下几个步骤:

![]()

其中对于最大概率模型来说,P(a1,a2...an)不是我们关心的问题,由此可以退化为如下表达式

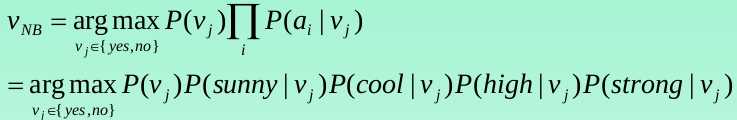

那么上述式子中P(a1,a2...an | vj )的求解是一个NP问题,所以需要简化,对于朴素贝叶斯来说:

![]()

vMAP可以退化为vNB,

![]()

对于经典天气问题,最终的朴素表达式如下:

标签:

原文地址:http://www.cnblogs.com/hitwhhw09/p/4618030.html