标签:

最速下降法的影子在机器学习中正是无处不在,它简单实用。

一、表示

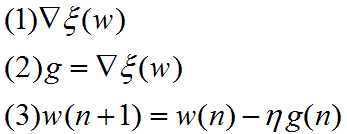

在最速下降法中,对权值向量w的连续调整是在最速下降的方向上,即它是与梯度向量方向相反的,梯度向量记为(1),简记(2):

其中,η是一个正常数,称为步长或学习率参数。g(n)是在w(n)处的梯度向量值。在从迭代n到n+1的过程中算法应用修正。

二、证明

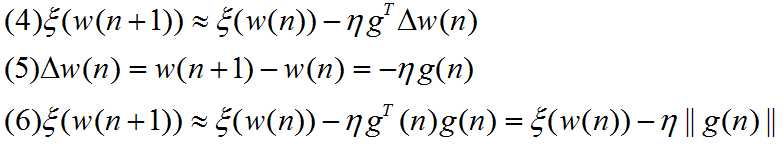

用w(n)附近的一阶泰勒级数展开来逼近,可写成(4)式

由(1)式得到(5)式,将(5)式代入(4)式,得到(6)式。显然是梯度下降的。

由(1)式得到(5)式,将(5)式代入(4)式,得到(6)式。显然是梯度下降的。

三、优缺点

缺点:局部极小值,而不是全局优化。只有目标函数是凸函数才是全局优化。

参考文献:《神经网络与机器学习》P59

标签:

原文地址:http://www.cnblogs.com/Wanggcong/p/4701703.html